In letzter Zeit haben so genannte »Deep Fakes« einiges an öffentlicher Aufmerksamkeit auf sich gezogen. Als Deep Fakes bezeichnet man täuschend echte Manipulationen von Bildern oder Videos, vornehmlich von Prominenten. Ein am Fraunhofer ITWM entwickeltes Tool zeigt, wie man diese Täuschungen schneller aufdecken kann – mit nahezu hundertprozentiger Sicherheit.

»Deep Fakes sind besorgniserregend«

Diese Einschätzung stammt von jemanden, der es wissen muss, nämlich Joaquin Candela, dem Leiter der KI-Entwicklung bei Facebook. Wer sich selbst von der hohen Qualität der Fälschungen überzeugen und gleichzeitig sein Urteilsvermögen testen will, kann dies zum Beispiel auf dieser Webseite tun: www.whichfaceisreal.com

Deep Fakes – also die Verwendung neuronaler Netzwerke zur Manipulation multimedialer Inhalte – werden erzeugt mittels generativer Modelle, auch »Generative Adversarial Networks« (GANs) genannt. Sie gelangen erst langsam in den Fokus der Wissenschaft. Und diese tut sich derzeit noch schwer, das Problem zu lösen, denn es gibt noch zu wenige valide Datensätze, mit denen sich belastbare Aussagen treffen lassen. Entsprechend hoch ist die Fehlerquote automatischer Systeme, die bisher zur schnellen Analyse von Bildern eingesetzt werden.

Abhilfe schafft hier eine neue mathematische Methode, die Forschende in Kaiserslautern, Mannheim und Offenburg entwickelt haben. Während die meisten derzeitigen Ansätze versuchen, wieder Lernalgorithmen einzusetzen, um die Manipulationen zu erkennen, geht die Forschergruppe einen anderen Weg:

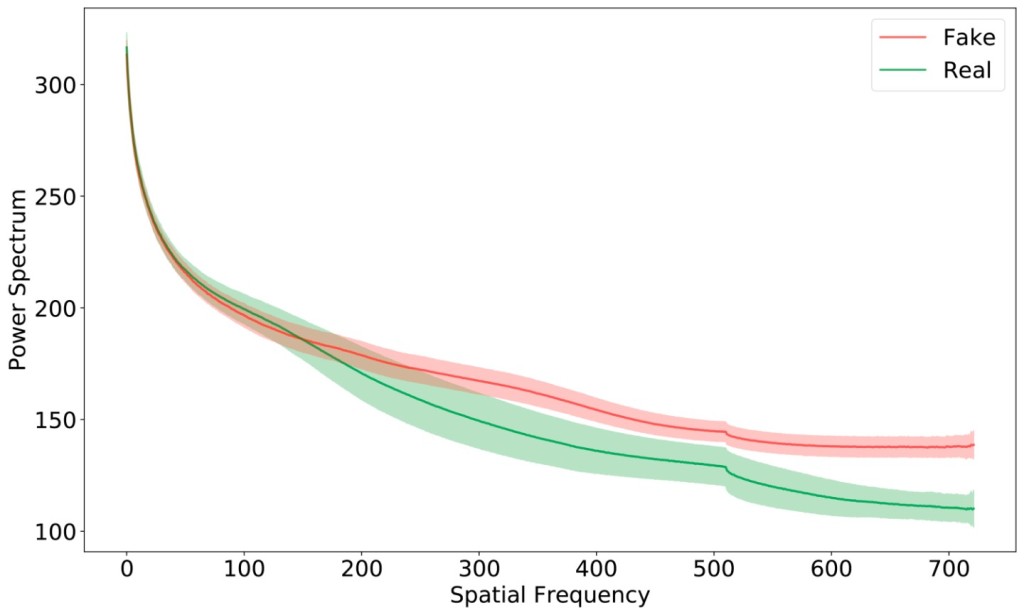

»Bei Analysen fiel auf, dass GANs beim Generieren von Bildern inhärente Fehler machen. Diese sind zwar für das menschliche Auge kaum sichtbar, lassen sich mathematisch aber sehr leicht im Fourier-Raum abbilden«, erläutert Dr. Janis Keuper, langjähriger Mitarbeiter des Fraunhofer ITWM und nun Professor für »Analytics and Data Science« an der Hochschule Offenburg.

Der Deep Fake-Detektor ermittelt

Die neue, am Fraunhofer ITWM entwickelte Methode hat gegenüber bestehenden Verfahren gleich mehrere Vorteile:

– Der entdeckte GAN-Fehler ist systematisch bedingt; daher ist es theoretisch unmöglich, dass derzeitige GAN-Architekturen lernen können, den Detektor zu umgehen.

– Es werden nur sehr wenige Beispieldatendaten benötigt, um Deep Fakes zuverlässig zu erkennen.

– Die Methode ist sehr einfach zu implementieren und benötigt vergleichsweise wenig Rechenleistung.

Bei einer ersten Auswertung auf öffentlichen Testdaten erreichte der neue Ansatz eine Genauigkeit von nahezu einhundert Prozent.

© Fraunhofer ITWM

Deep Fake-Detektor: nach der mathematischen Abbildung lassen sich echte und Gefälschte Bilder leicht unterscheiden.

Quelle Text/Bild:

Fraunhofer-Institut für Techno- und Wirtschaftsmathematik

Fraunhofer-Platz 1

67663 Kaiserslautern

www.itwm.fraunhofer.de

Kaiserslautern, 09.03.2020